Ein neues Schreckensgespenst zieht durch die heiligen Gänge der CIOs. Was die einen noch nicht so richtig verstehen, ist bei anderen zu einem realen Problem geworden: Big Data. EMC, einer der führenden Datenspeicher-Lösungen rechnet in einer Studie 2011 vor, dass sich die Datenmenge ca. alle 2 Jahre verdoppelt. Wir sprechen mittlerweile von Zettabytes, was einer Billion Gigabytes entspricht. Das ist nun wirklich eine Riesenmenge an Datensätzen. Diese Mengen können mit traditionellen Mitteln und Systemen schlicht nicht mehr sinnvoll analysiert und verarbeitet werden, wie dies heute in der Online-Verarbeitung notwendig ist. Das tönt jetzt primär nach technischen Limitationen, ist aber bei genauerem Hinschauen nicht nur ein quantitatives, sondern vor allem auch ein qualitatives und strukturelles Problem im digitalen Informationszeitalter.

Ein neues Schreckensgespenst zieht durch die heiligen Gänge der CIOs. Was die einen noch nicht so richtig verstehen, ist bei anderen zu einem realen Problem geworden: Big Data. EMC, einer der führenden Datenspeicher-Lösungen rechnet in einer Studie 2011 vor, dass sich die Datenmenge ca. alle 2 Jahre verdoppelt. Wir sprechen mittlerweile von Zettabytes, was einer Billion Gigabytes entspricht. Das ist nun wirklich eine Riesenmenge an Datensätzen. Diese Mengen können mit traditionellen Mitteln und Systemen schlicht nicht mehr sinnvoll analysiert und verarbeitet werden, wie dies heute in der Online-Verarbeitung notwendig ist. Das tönt jetzt primär nach technischen Limitationen, ist aber bei genauerem Hinschauen nicht nur ein quantitatives, sondern vor allem auch ein qualitatives und strukturelles Problem im digitalen Informationszeitalter.

Lange dachte man, dass mit den immer billiger werdenden Speichermedien das Datenmengenproblem nicht wirklich existiert. Datenbeschaffen war die Devise – Platz hat es auf den ebenfalls immer kleiner werdenden Datenträgern eh genug. Datenbanktechnologien stossen aber irgendwann mal an die Grenzen bei der Verarbeitung von Businessdaten, insbesondere jene, die nicht skalieren können. Lange Zeit konnten mit ineffizienten Methoden der Zugriff und die Manipulation der Daten durch die Anschaffung von immer schnelleren und grösseren Hardware-Systemen kaschiert werden. Noch bis vor kurzem hat das auch niemand wirklich gestört, da die Kosten der Technologie immer günstiger wurden und der Betrieb und Unterhalt der Daten nicht im primären Fokus des CIOs waren.

Lange dachte man, dass mit den immer billiger werdenden Speichermedien das Datenmengenproblem nicht wirklich existiert. Datenbeschaffen war die Devise – Platz hat es auf den ebenfalls immer kleiner werdenden Datenträgern eh genug. Datenbanktechnologien stossen aber irgendwann mal an die Grenzen bei der Verarbeitung von Businessdaten, insbesondere jene, die nicht skalieren können. Lange Zeit konnten mit ineffizienten Methoden der Zugriff und die Manipulation der Daten durch die Anschaffung von immer schnelleren und grösseren Hardware-Systemen kaschiert werden. Noch bis vor kurzem hat das auch niemand wirklich gestört, da die Kosten der Technologie immer günstiger wurden und der Betrieb und Unterhalt der Daten nicht im primären Fokus des CIOs waren.

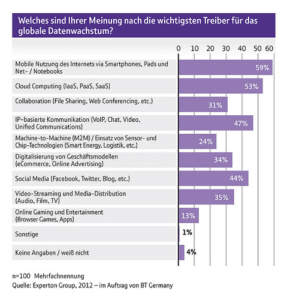

Mit der zunehmenden Verbreitung von mobilen Apps und sozialen Netzen sind Unternehmen mit zig-tausend Online-Usern konfrontiert, welche alle ihre Datenspuren hinterlassen. Um sich im digitalen Universum behaupten zu können, sind diese Daten für Unternehmen in Zukunft eminent wichtig und müssen analysiert werden. Was lange ethisch verpönt war, ist heute eine simple Marketing- und Vertriebsvoraussetzung: Das Nutzerverhalten muss gezielter erfasst werden, um noch näher beim Endkunden zu sein und ihn stärker binden zu können. Daher werden diese Daten gesammelt, was das Zeug hält. Bilder, Videos, Chats und was mobile Anwender alles so an Datenspuren hinterlassen. Big Data ist also nicht bloss ein Mengenproblem zur effizienten Verarbeitung von unstrukturierten Daten – es ist vielmehr ein neues Business-Phänomen, in welchem die Daten selbst zum Service werden. CIOs sind gefordert, den strategischen Wert der Daten im Unternehmen deutlich zu machen.

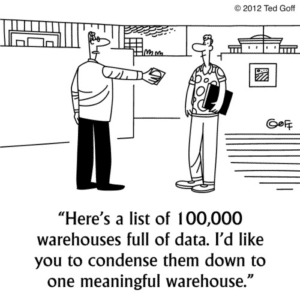

Technologien zur Verarbeitung solcher riesigen Datenmengen sind zwar laufend am Entstehen – aber damit kann das Problem selbst nicht gelöst werden. Auch Service Provider, welche sich auf die Verarbeitung grosser Datenmengen spezialisiert haben, sind nicht die Lösung alleine. Big Data ist nicht eine rein technische Herausforderung, sondern setzt qualitatives Daten-Management voraus. Um das Phänomen nicht durch die Hintertür via unkontrollierte Cloud-Provider zum echten Problem anwachsen zu lassen, ist ein von starkem Business- und Technologie-Verständnis geprägtes Information-Management als Basis-Dienstleistung der IT gefordert.

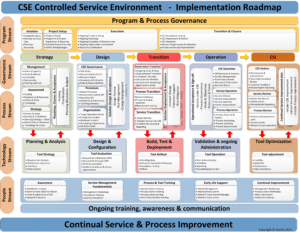

Solch ein Information-Management Service muss durch ein kontrolliertes Service Management System (CSE – Controlled Service Environment) gesteuert und sichergestellt werden. Die LifeCycle Planung der Daten ist eng mit dem Business abzustimmen und im Alltag durch professionelle Dienstleistungen der IT sicherzustellen. Einerseits müssen Informationen von verschiedensten Datenquellen kombiniert und sofort analysiert werden können und andererseits müssen die dazu notwendigen Infrastrukturen rechtzeitig geplant werden um den zu erwartenden Workload verkraften zu können. Dabei ist nicht nur die strukturierte Sammlung und Pflege der Daten ist wichtig, sondern bewusste und rechtzeitige Entsorgung ist genauso von Bedeutung.

Daten sind das Rohmaterial eines jeden Unternehmens. Aber anstelle diese hinter Applikationsmasken und Datenbanksystemen eher passiv verkümmern zu lassen, steht hier für clevere Service Provider ein Riesenpotential zur Positionierung als aktiver Datenanalyse-Lieferant zur Verfügung. Nicht blosses Adhoc-Reporting am Service Desk sondern als tragende Säule zur Unterstützung der Business-Einheiten wie beispielsweise Marketing, Vertrieb oder Logistik.

Die Umsetzung einer Big Data Initiative bedingt dabei nicht die blosse Beschaffung von neuen Infrastrukturen oder die Auslagerung an potentiell geeignete Lieferanten. Vielmehr ist ein Betriebsumfeld so zu schaffen, dass die Daten kontrolliert wachsen und verarbeiten werden können. Die Best Practice Ansätze von ITIL® oder COBIT® bieten dabei sehr gute Grundlagen – nur geht es dabei nicht bloss um das Einrichten von einzelnen Prozessen sondern vielmehr um das Verzahnen des Information Management Services mit dem Service Management System – der Aufbau eines Controlled Service Environments, CSE.

Während viele IT Manager noch über Bedeutung und Entwicklung des Begriffs Big Data rätseln, richten sich findige CIOs bereits darauf aus und positionieren ihre IT Organisationen neu. Wie gross Big Data jetzt wirklich ist, muss nicht die Infrastruktur durch ihr Versagen ankündigen. Vielmehr gilt es den Wert der Daten richtig einzuschätzen und für das Unternehmen gewinnbringend und zukunftssichernd zur Verfügung zu stellen.

Ein Spiegel der Gesellschaft – we are overnews’ed and underinformed ein Perpetuum mobile…